こんにちは。パロアルトインサイトCEO・AIビジネスデザイナーの石角友愛です。

グーグルのAI開発における倫理性などを研究し、提言にまとめることが目的の「Ethical Artificial Intelligence Team(倫理的AIチーム、EAIT)」 の共同リードだったコンピューターサイエンティストのティムニット・ゲブル(Timnit Gebru、本人のTwitter公式アカウントはこちら)氏が、2020年12月に突然グーグルから解雇された——というのは1年前の年末にTech業界で話題になったニュースでした(もっとも、グーグルはゲブル氏が自主退職したと主張しており、両者の意見は一致していません)。

そのゲブル氏が、1年経った2021年12月にイギリスの大手メディアであるガーディアンで「For truly ethical AI, its research must be independent from big tech(真に倫理的なAI開発のためには、ビッグテックから独立して研究しなければならない)」という題の寄稿文を発表しました。

寄稿文の中には、彼女が突然グーグルから解雇された理由や、解雇後の2021年にビッグテック企業に対する内部告発が増えたことなどが描かれています。特に、メタ(旧フェイスブック)傘下のインスタグラムに関する調査で、インスタグラムの使用が10代の女性の精神面に良い影響を与えないことを認識しながらも、何も対処せずにユーザー数増加と利益追求に注力し続けていた問題行為などを内部告発したフランシス・ホーゲン氏(Frances Haugen)の米議会での証言を「最も注目を浴びた」と評価しました。

以下は、彼女の文章の一部を抜粋・意訳したものです。

そもそもゲブル氏がグーグル在籍時代に進めていた研究はどんなものだったのでしょうか?

解雇問題の発端となった研究は、2019年に始まりました。MITテクノロジーレビューの調査によると、ゲブル氏が発表した「確率変数のオウムの危険性について:言語モデルは大きくなり過ぎる可能性があるのか?(On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?)」と題した論文では、「膨大な量のテキストデータで、大規模な言語モデルを学習させることで生じうるさまざまなリスク」について警鐘を鳴らしています。

例えば、AIのバイアス(偏向)に関するリスクについては、

とした上で、「そういった状況にもかかわらず、開発者の間でこれらのリスクを軽減するための十分な検討がなされてきただろうか?」といった疑問を投げかけています。

ゲブル氏解雇後の世間の反応を見ると、1400人以上のグーグル社員の署名や、その他1900人の支援者の署名などが集まるなど、彼女の解雇が多くの反発を生んだことがうかがえます。アルファベットCEOのサンダー・ピチャイ氏は、会社として間違った行為などは認めていないものの、ゲブル氏に対して社員宛てのメールの中で正式謝罪をしました。

現在のアメリカでは、巨大IT企業に対する倫理的責任の追及が加速しています。

インターネットや今後の大きなフロンティアと言われているメタバースなどの大きな市場、巨大IT企業は、OSやプラットフォーマーといった立ち位置を維持しようと、力とデータを蓄え続けて成長してきました。今後、どのように倫理性を担保すればよいのでしょうか。

倫理性を担保する鍵は、社内で「忖度なしの独立したデータ分析」ができる体制を構築することにあると言えます。

例えば、メタ社では2021年にRAI(Responsible AI、責任あるAI)チームをAI事業の中に作りました。RAIとは、過去数年間アメリカのAI関連の業界で話題になっている言葉です。

これまでは、説明可能なAI(XAI=Explainable AI)を作るということがAIの倫理性を担保する上での基準とされてきました。が、最近では、AIを使用する組織や開発する人たちへの責任感をより強く持たせるために、RAIへシフトする動きが目立ちます。例えば、アメリカ国防省でもRAIのガイドラインを発表しています。メタも、同じようにXAIからRAIへシフトしていると言えるのかもしれません。

ここで、Organimi社より公開されているメタになる前のフェイスブック(2021年3月時点)の組織体制図をご紹介します。この組織体制図によると、CEOのマーク・ザッカーバーグ氏の下にCTOがいます。そして、そのCTOが管理している事業の一つがAI事業です。このことから、会社の事業としてAIが重要な位置付けにあることがうかがえます。RAIは、そのAI事業の中に、横断的なチームとして設立されたと公式ブログに書かれています。

Heres a look at the @Facebook executive structure.

Make your own sleek org chart with Organimi ?https://t.co/ycxDQ6WCiR pic.twitter.com/bgaB1Xnzkn— Organimi Org Charts (@Organimi) March 25, 2021

公式サイトによると、このRAIチームは「FacebookにおけるAIが人々と社会に利益をもたらすものにする」という命題を掲げ、外部の専門家や規制当局と定期的に協議・協力しながら、機械学習(ML)システムの責任ある設計と、使用を担保するためのアプローチを構築し、テストしているそうです。

また、RAIの5つの柱として、以下のものが挙げられています。

1. プライバシーとセキュリティ(ユーザー情報の収集や解析に関して、プロダクト横断的にプライバシーレビューを行う)

2. 公平性とインクルージョン(AIモデルや学習データのラベルに関するバイアスがないかどうかをプロセス実装により検知するFairness Flowの構築)

3. ロバスト性※と安全性(AIの敵対的攻撃を察知し安全性を担保するための、AI red teamを作り、プロダクト横断的に検知する取り組み。同時に、マイクロソフト、大学などと連携しディープフェイクを検知するコンペティションを実施。業界全体で底上げをするためのイニシアチブの計画や運営)

4. 透明性とコントロール(ニュースフィードの検索結果のランクを決めるアルゴリズムに対して、ユーザーが調整ができるようなFavorites機能の実装や、政治広告の非表示化など)

5. アカウンタビリティとガバナンス(四半期に1回Community Standards Enforcement Reportを発表し、フェイスブックやインスタグラムが責任あるAI実現に向けてどれくらい効果を出したかを調査して発表する取り組みなど)

※外乱の影響を受けづらいかどうかの性質のこと

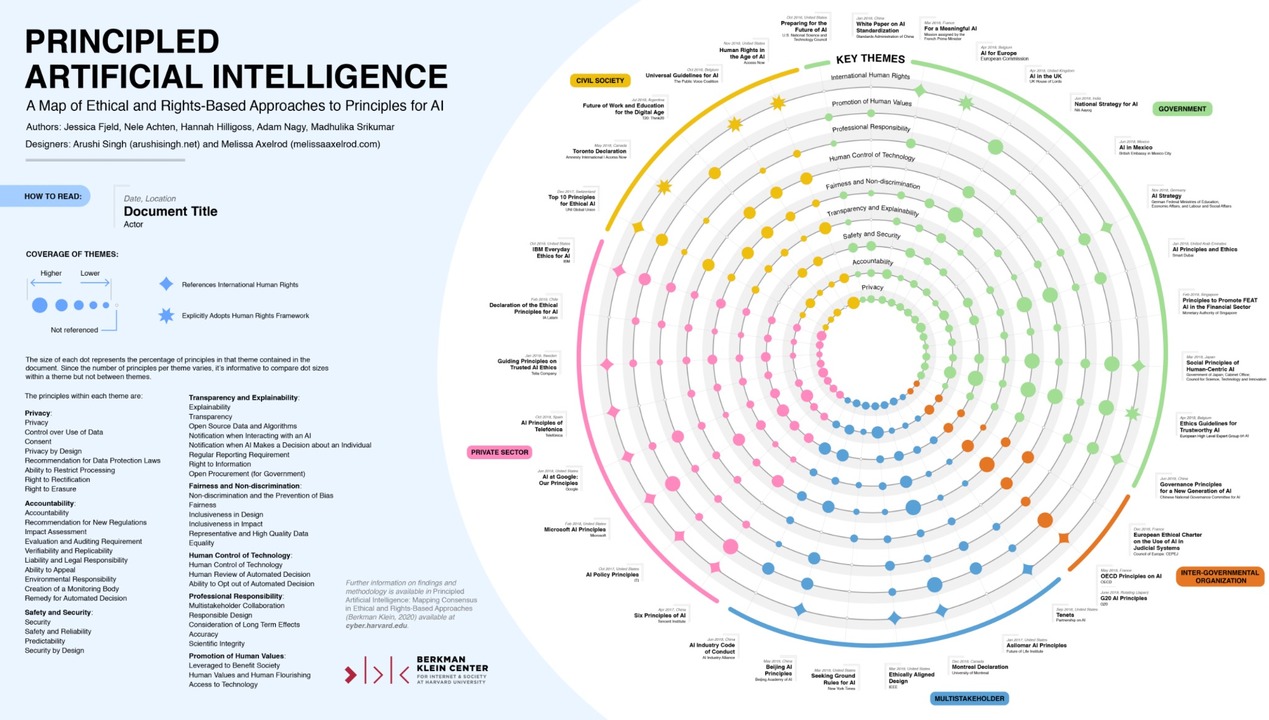

「倫理的なAI」という枠組みで企業や政府、市民団体などの取り組みを議論する際に、上記のような細分化したテーマや柱を明確にすることは、重要なポイントです。なお、メタの5つのRAIの柱は、ハーバード大学が提唱する倫理的AIの原則で紹介されているテーマに沿って作られたということで、その内容をほぼ網羅する形で設定されていることが分かります。

また、5つの柱の中でも特に、メタやインスタグラムが、企業としてRAI推進のために機能しているかどうかをチェックする目的で公表しているという「Community Standards Enforcement Report」は非常に興味深い内容です。

最新のレポートを読んでいると、以下のカテゴリーに代表される、11種類の問題コンテンツを5つのメトリクスで効果検証しています。

責任あるAIプロジェクトの効果検証をするための5つのメトリクス

AIの活用提案から、ビジネスモデルの構築、AI開発と導入まで一貫した支援を日本企業へ提供する、石角友愛氏(CEO)が2017年に創業したシリコンバレー発のAI企業。

社名 :パロアルトインサイトLLC

設立 :2017年

所在 :米国カリフォルニア州 (シリコンバレー)

メンバー数:17名(2021年9月現在)

パロアルトインサイトHP:www.paloaltoinsight.com

お問い合わせ、ご質問などはこちらまで:info@paloaltoinsight.com

2010年にハーバードビジネススクールでMBAを取得したのち、シリコンバレーのグーグル本社で多数のAI関連プロジェクトをシニアストラテジストとしてリード。その後HRテック・流通系AIベンチャーを経てパロアルトインサイトをシリコンバレーで起業。東急ホテルズ&リゾーツのDXアドバイザーとして中長期DX戦略への助言を行うなど、多くの日本企業に対して最新のDX戦略提案からAI開発まで一貫したAI・DX支援を提供する。2024年より一般社団法人人工知能学会理事及び東京都AI戦略会議 専門家委員メンバーに就任。

AI人材育成のためのコンテンツ開発なども手掛け、順天堂大学大学院医学研究科データサイエンス学科客員教授(AI企業戦略)及び東京大学工学部アドバイザリー・ボードをはじめとして、京都府アート&テクノロジー・ヴィレッジ事業クリエイターを務めるなど幅広く活動している。

毎日新聞、日経xTREND、ITmediaなど大手メディアでの連載を持ち、 DXの重要性を伝える毎週配信ポッドキャスト「Level 5」のMCや、NHKラジオ第1「マイあさ!」内「マイ!Biz」コーナーにレギュラー出演中。「報道ステーション」「NHKクローズアップ現代+」などTV出演も多数。

著書に『AI時代を生き抜くということ ChatGPTとリスキリング』(日経BP)『いまこそ知りたいDX戦略』『いまこそ知りたいAIビジネス』(ディスカヴァー・トゥエンティワン)、『経験ゼロから始めるAI時代の新キャリアデザイン』(KADOKAWA)、『才能の見つけ方 天才の育て方』(文藝春秋)など多数。

実践型教育AIプログラム「AIと私」:https://www.aitowatashi.com/

お問い合わせ、ご質問などはこちらまで:info@paloaltoinsight.com

|

|

※石角友愛の著書一覧

毎週水曜日、アメリカの最新AI情報が満載の

ニュースレターを無料でお届け!

その他講演情報やAI導入事例紹介、

ニュースレター登録者対象の

無料オンラインセミナーのご案内などを送ります。